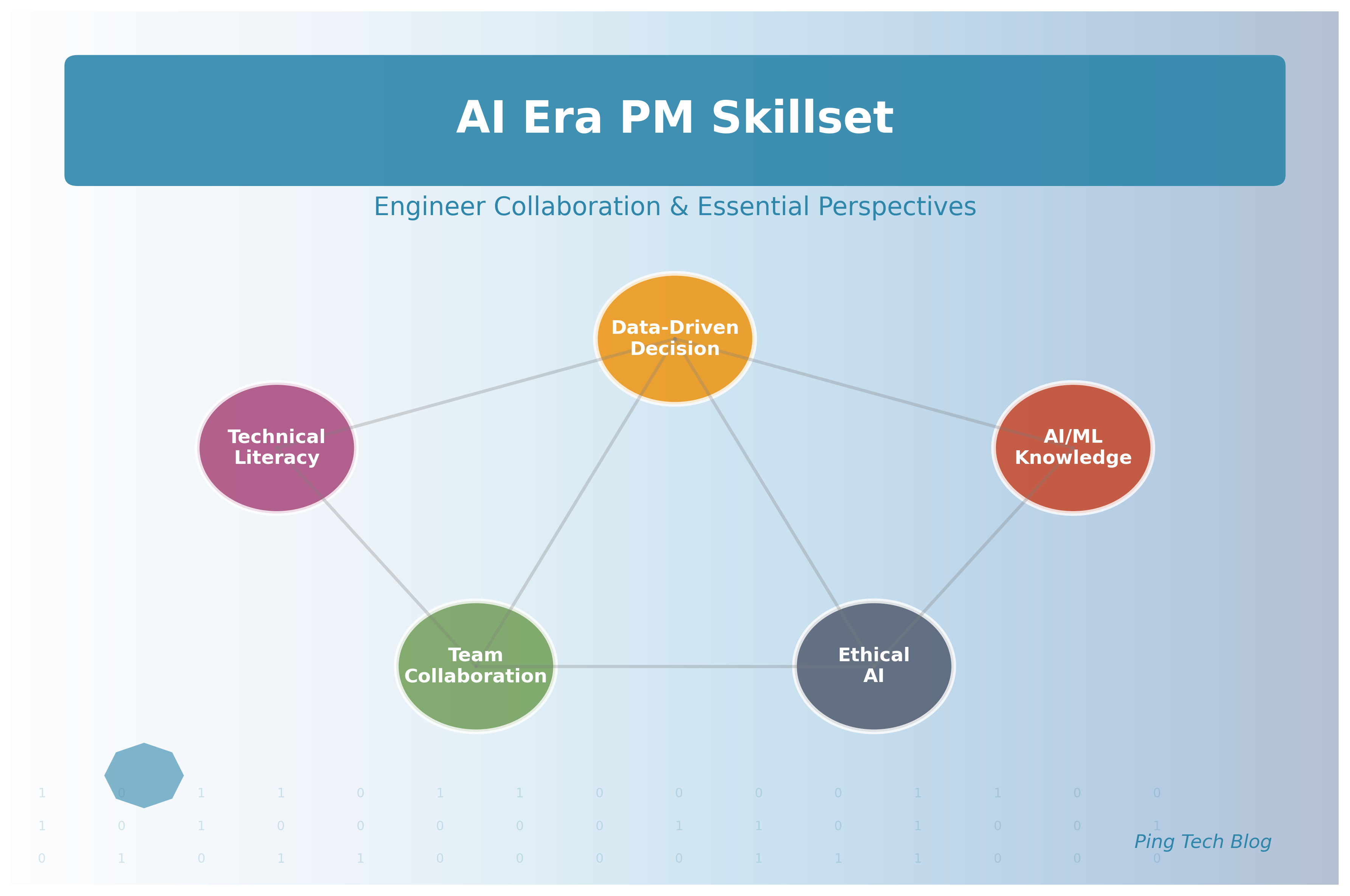

AI技術の爆発的な普及により、プロダクトマネージャー(PM)の役割は根本的な転換期を迎えています。従来のビジネス要件定義や優先度管理に加えて、機械学習アルゴリズムへの深い理解、データサイエンスの基礎知識、そしてエンジニアリングチームとの高度な技術的協業が必須スキルとなりました。McKinsey Global Instituteの調査によると、2025年までにAI関連プロジェクトに関わるPMの需要は300%増加すると予測されています。本記事では、この変革期において成功するPMが習得すべき包括的なスキルセットと、エンジニアチームとの生産的な共創を実現するための実践的アプローチについて、具体的な事例とともに詳細に解説します。現代のテクノロジー企業において、AIを活用したプロダクト開発は競争優位性を決定する重要な要素となっており、PMには従来以上の技術的洞察力と戦略的思考が求められています。

AI時代のPMに求められる根本的な変化

従来のPMモデルからの脱却

従来のプロダクトマネジメントは、明確な要件定義、線形的な開発プロセス、そして予測可能な成果を前提としていました。しかし、AI・機械学習の世界では、この前提が根本的に覆されます。

不確実性への対応力

AI開発における最大の特徴は、その高い不確実性です。機械学習モデルの性能は、データの質、アルゴリズムの選択、ハイパーパラメータの調整など、多くの要因に左右されます。PMは、この不確実性を受け入れ、柔軟に対応する能力が必要です。

- 確率的思考の習得: 「成功確率70%のアプローチA」と「成功確率40%だが高いリターンのアプローチB」を比較検討する思考法

- 実験設計スキル: 仮説検証のための適切な実験デザインと統計的解釈

- リスク管理: 技術的リスクとビジネスリスクの両面からの評価

# 実験設計の例:A/Bテストでの統計的有意性判定

import scipy.stats as stats

import numpy as np

def calculate_significance(control_conversions, control_visitors,

treatment_conversions, treatment_visitors):

"""

A/Bテストの統計的有意性を計算

PMが理解すべき基本的な統計概念の実装例

"""

control_rate = control_conversions / control_visitors

treatment_rate = treatment_conversions / treatment_visitors

# プールされた標準エラーの計算

pooled_prob = (control_conversions + treatment_conversions) / (control_visitors + treatment_visitors)

pooled_se = np.sqrt(pooled_prob * (1 - pooled_prob) * (1/control_visitors + 1/treatment_visitors))

# z統計量の計算

z_stat = (treatment_rate - control_rate) / pooled_se

p_value = 2 * (1 - stats.norm.cdf(abs(z_stat)))

return {

'control_rate': control_rate,

'treatment_rate': treatment_rate,

'lift': (treatment_rate - control_rate) / control_rate * 100,

'p_value': p_value,

'significant': p_value < 0.05

}

# 実際の使用例

result = calculate_significance(150, 1000, 180, 1000)

print(f"Control Rate: {result['control_rate']:.3f}")

print(f"Treatment Rate: {result['treatment_rate']:.3f}")

print(f"Lift: {result['lift']:.1f}%")

print(f"P-value: {result['p_value']:.4f}")

print(f"Statistically Significant: {result['significant']}")

データ中心の意思決定プロセス

AI時代のPMは、直感や経験だけでなく、データに基づいた意思決定を行う必要があります。これには、データの収集、分析、解釈のすべての段階で適切な判断を下す能力が求められます。

データリテラシーの向上

- データの品質評価: 欠損値、外れ値、バイアスの特定と対処法

- 統計的推論: 相関と因果関係の区別、信頼区間の理解

- ビジネスメトリクスとの連携: 技術指標をビジネス成果に変換する能力

技術的理解の深化:必須知識領域

機械学習の基礎概念とプロダクトへの応用

PMは機械学習の専門家である必要はありませんが、基本的な概念と制約を理解することで、エンジニアとの議論をより建設的に進めることができます。

教師あり学習の理解

# 分類問題の評価指標を理解するための例

from sklearn.metrics import classification_report, confusion_matrix

import pandas as pd

# 実際のプロダクトでの予測結果例

y_true = [1, 0, 1, 1, 0, 1, 0, 0, 1, 0] # 実際のラベル

y_pred = [1, 0, 1, 0, 0, 1, 1, 0, 1, 0] # モデルの予測

# 混同行列の生成

cm = confusion_matrix(y_true, y_pred)

print("Confusion Matrix:")

print(cm)

# 詳細な分類レポート

report = classification_report(y_true, y_pred, output_dict=True)

print(f"\nPrecision: {report['1']['precision']:.3f}")

print(f"Recall: {report['1']['recall']:.3f}")

print(f"F1-Score: {report['1']['f1-score']:.3f}")

# ビジネス的な解釈

print("\nビジネス的な解釈:")

print(f"True Positives: {cm[1][1]} (正しく検出した重要なケース)")

print(f"False Positives: {cm[0][1]} (誤検出、コスト増)")

print(f"False Negatives: {cm[1][0]} (見逃し、機会損失)")

教師なし学習の活用場面

- クラスタリング: ユーザーセグメンテーション、商品カテゴライゼーション

- 次元削減: 大規模データの可視化、特徴量選択

- 異常検知: セキュリティ、品質管理、不正検出

深層学習とNLPの理解

現代のAIプロダクトの多くが深層学習やNLP(自然言語処理)技術を活用しています。PMはこれらの技術の可能性と限界を理解する必要があります。

Transformer Architecture の基本理解

# 簡単なAttention機構の概念を理解するための例

import numpy as np

def simple_attention(query, key, value):

"""

簡略化されたAttention機構の実装

PMが理解すべきTransformerの核心概念

"""

# Attention重みの計算

scores = np.dot(query, key.T)

attention_weights = np.exp(scores) / np.sum(np.exp(scores))

# 重み付き和の計算

output = np.dot(attention_weights, value)

return output, attention_weights

# 使用例:文書要約における重要文の選択

sentences = np.array([

[0.1, 0.2, 0.3], # 文1のベクトル表現

[0.4, 0.5, 0.6], # 文2のベクトル表現

[0.7, 0.8, 0.9] # 文3のベクトル表現

])

query = np.array([0.5, 0.5, 0.5]) # クエリベクトル

output, weights = simple_attention(query, sentences, sentences)

print("Attention Weights:", weights)

print("Output:", output)

MLOpsとプロダクション運用

AI/MLシステムの実際の運用では、モデルの継続的な監視、更新、そして改善が不可欠です。PMはこのMLOpsの概念を理解し、適切な運用体制を構築する必要があります。

モデルライフサイクル管理

# MLOpsパイプラインの設定例

# PMがエンジニアと協議する際の技術仕様書

model_pipeline:

data_ingestion:

source: "production_database"

frequency: "daily"

validation_rules:

- "schema_validation"

- "data_drift_detection"

- "outlier_detection"

model_training:

trigger: "data_quality_passed"

algorithm: "ensemble_methods"

hyperparameter_tuning: "bayesian_optimization"

cross_validation: "time_series_split"

model_evaluation:

metrics:

- "accuracy"

- "precision_recall"

- "business_metrics"

threshold:

accuracy: 0.85

business_impact: "positive"

deployment:

strategy: "blue_green"

rollback_conditions:

- "accuracy_drop > 5%"

- "latency > 200ms"

- "error_rate > 1%"

monitoring:

real_time_metrics:

- "prediction_latency"

- "model_drift"

- "data_quality"

alerting:

channels: ["slack", "email"]

escalation_policy: "follow_sun"

エンジニアチームとの効果的な協業戦略

技術的コミュニケーションの向上

PMとエンジニアの間で効果的なコミュニケーションを実現するためには、共通の技術言語を構築することが重要です。

技術仕様書の共同作成

# 推薦システム技術仕様書(PM-エンジニア共同作成版)

## ビジネス要件

- **目標**: ユーザーのクリック率を20%向上

- **制約条件**: レスポンス時間100ms以内、コスト月額10万円以内

- **成功指標**: CTR、CVR、ユーザー満足度スコア

## 技術要件

### データ要件

- **ユーザー行動データ**: 過去12ヶ月分、100万ユーザー

- **商品データ**: カテゴリ、価格、在庫状況

- **コンテキストデータ**: 时间、デバイス、位置情報

### モデル要件

- **アルゴリズム**: Collaborative Filtering + Content-based

- **更新頻度**: リアルタイム(ユーザー行動)+ バッチ(商品特徴)

- **A/Bテスト**: 新規ユーザーの10%でテスト実施

### インフラ要件

- **計算資源**: CPU 4コア、メモリ16GB、GPU不要

- **データベース**: Redis(リアルタイム)+ PostgreSQL(履歴)

- **API**: RESTful、JSON形式、認証あり

アジャイル開発における新しいアプローチ

AI開発の不確実性を考慮した、従来のアジャイル手法を拡張したアプローチが必要です。

スクラムの拡張:AIスクラム

# AIスクラムのベロシティ計算例

class AIScrum:

def __init__(self):

self.story_points = []

self.model_accuracy = []

self.research_spikes = []

def calculate_ai_velocity(self, sprint_data):

"""

AI開発特有の要素を考慮したベロシティ計算

"""

completed_points = sum(sprint_data['completed_stories'])

accuracy_bonus = sprint_data['accuracy_improvement'] * 10

research_penalty = len(sprint_data['unresolved_research']) * 2

adjusted_velocity = completed_points + accuracy_bonus - research_penalty

return {

'base_velocity': completed_points,

'accuracy_bonus': accuracy_bonus,

'research_penalty': research_penalty,

'adjusted_velocity': max(0, adjusted_velocity)

}

def plan_next_sprint(self, team_capacity, historical_velocity):

"""

次スプリントの計画立案

"""

confidence_factor = 0.8 # AI開発の不確実性を考慮

planned_capacity = team_capacity * confidence_factor

return {

'planned_stories': planned_capacity,

'research_buffer': team_capacity * 0.2,

'risk_mitigation': "実験的機能は最小限に"

}

# 使用例

scrum = AIScrum()

sprint_result = scrum.calculate_ai_velocity({

'completed_stories': [3, 5, 8, 2],

'accuracy_improvement': 0.05,

'unresolved_research': ['feature_engineering', 'hyperparameter_tuning']

})

print(f"Adjusted Velocity: {sprint_result['adjusted_velocity']}")

継続的な学習とスキル向上

AI技術の急速な進歩に対応するため、チーム全体での継続的な学習が不可欠です。

学習プログラムの設計

- 週次技術勉強会: 最新の論文、技術トレンドの共有

- ハンズオン・ワークショップ: 新しいフレームワークやツールの実践的学習

- 外部エキスパートとの交流: 学会、カンファレンス、オンラインコミュニティへの参加

# チーム学習進捗の可視化例

import matplotlib.pyplot as plt

import pandas as pd

def visualize_team_learning(team_data):

"""

チームの学習進捗を可視化

"""

skills = ['Machine Learning', 'Deep Learning', 'MLOps', 'Statistics', 'Python']

fig, ax = plt.subplots(figsize=(10, 6))

for member in team_data:

ax.plot(skills, member['scores'], marker='o', label=member['name'])

ax.set_ylabel('Skill Level (1-10)')

ax.set_title('Team AI Skills Development')

ax.legend()

ax.grid(True, alpha=0.3)

plt.xticks(rotation=45)

plt.tight_layout()

plt.show()

# データ例

team_learning_data = [

{'name': 'PM', 'scores': [6, 4, 7, 8, 5]},

{'name': 'Engineer A', 'scores': [9, 8, 8, 7, 9]},

{'name': 'Engineer B', 'scores': [7, 9, 6, 6, 8]},

{'name': 'Data Scientist', 'scores': [10, 9, 7, 10, 9]}

]

# 実行例(コメント形式で記載)

# visualize_team_learning(team_learning_data)

組織・チーム設計における戦略的アプローチ

クロスファンクショナルチーム構成の最適化

AI開発プロジェクトでは、多様な専門性を持つメンバーの効果的な協業が成功の鍵となります。

役割定義とスキルマトリクス

役割 | 主要責任 | 必要スキル | PMとの協業レベル |

|---|---|---|---|

ML Engineer | モデル実装・最適化 | Python, TensorFlow, PyTorch | 高(技術的意思決定) |

Data Engineer | データパイプライン構築 | SQL, Apache Spark, AWS | 中(データ品質管理) |

Data Scientist | 分析・仮説検証 | 統計学, R, 可視化 | 高(ビジネス洞察) |

DevOps Engineer | インフラ・運用 | Docker, Kubernetes, CI/CD | 中(運用要件定義) |

Frontend Engineer | UI/UX実装 | React, TypeScript, デザイン | 中(ユーザー体験) |

QA Engineer | テスト・品質保証 | テスト設計, 自動化 | 中(品質基準) |

パフォーマンス評価とキャリア開発

AI時代のチーム運営では、従来の評価指標に加えて、技術的成長とイノベーション創出を評価する仕組みが必要です。

OKR(Objectives and Key Results)の設計例

# AI開発チームのOKR例

quarterly_okr:

objective: "顧客満足度を向上させるAI機能を提供する"

key_results:

- metric: "モデル精度"

target: "85%以上"

current: "78%"

owner: "ML Engineer"

- metric: "レスポンス時間"

target: "100ms以下"

current: "150ms"

owner: "DevOps Engineer"

- metric: "ユーザー満足度"

target: "4.5/5.0以上"

current: "4.1/5.0"

owner: "PM"

- metric: "技術的負債削減"

target: "コードカバレッジ80%"

current: "65%"

owner: "QA Engineer"

individual_okr:

pm_objectives:

- "AI技術理解の深化"

- "エンジニアとの協業品質向上"

- "データドリブン意思決定の実践"

engineer_objectives:

- "新技術の習得と実装"

- "知識共有とメンタリング"

- "プロダクト価値への貢献"

倫理的AI開発とリスク管理

AIバイアス対策の体系的アプローチ

AI システムの公平性と透明性を確保することは、PMの重要な責任です。

バイアス検出と軽減のフレームワーク

# AIバイアス検出の実装例

import pandas as pd

import numpy as np

from sklearn.metrics import confusion_matrix

class BiasDetector:

def __init__(self, protected_attributes):

self.protected_attributes = protected_attributes

def calculate_demographic_parity(self, df, prediction_col, protected_attr):

"""

デモグラフィック・パリティの計算

"""

groups = df.groupby(protected_attr)[prediction_col].mean()

max_diff = groups.max() - groups.min()

return {

'groups': groups.to_dict(),

'max_difference': max_diff,

'is_fair': max_diff < 0.1 # 10%以内なら公平とみなす

}

def calculate_equalized_odds(self, df, prediction_col, actual_col, protected_attr):

"""

等化オッズの計算

"""

results = {}

for group_value in df[protected_attr].unique():

group_data = df[df[protected_attr] == group_value]

# True Positive Rate

tpr = group_data[(group_data[actual_col] == 1) &

(group_data[prediction_col] == 1)].shape[0] / \

group_data[group_data[actual_col] == 1].shape[0]

# False Positive Rate

fpr = group_data[(group_data[actual_col] == 0) &

(group_data[prediction_col] == 1)].shape[0] / \

group_data[group_data[actual_col] == 0].shape[0]

results[group_value] = {'tpr': tpr, 'fpr': fpr}

return results

def generate_bias_report(self, df, prediction_col, actual_col):

"""

バイアス検出レポートの生成

"""

report = {}

for attr in self.protected_attributes:

demographic_parity = self.calculate_demographic_parity(

df, prediction_col, attr)

equalized_odds = self.calculate_equalized_odds(

df, prediction_col, actual_col, attr)

report[attr] = {

'demographic_parity': demographic_parity,

'equalized_odds': equalized_odds

}

return report

# 使用例

bias_detector = BiasDetector(['gender', 'age_group', 'ethnicity'])

# サンプルデータ(実際にはプロダクションデータを使用)

sample_data = pd.DataFrame({

'gender': ['M', 'F', 'M', 'F', 'M', 'F'] * 100,

'age_group': ['young', 'old'] * 300,

'prediction': np.random.binomial(1, 0.7, 600),

'actual': np.random.binomial(1, 0.6, 600)

})

bias_report = bias_detector.generate_bias_report(

sample_data, 'prediction', 'actual')

print("Bias Detection Report:")

for attr, results in bias_report.items():

print(f"\n{attr}:")

print(f" Demographic Parity: {results['demographic_parity']['is_fair']}")

print(f" Max Difference: {results['demographic_parity']['max_difference']:.3f}")

プライバシー保護とデータガバナンス

# プライバシー保護の実装例

import hashlib

import random

class PrivacyPreservingPM:

def __init__(self):

self.anonymization_mappings = {}

def k_anonymize(self, df, quasi_identifiers, k=5):

"""

K-匿名化の実装

"""

# 簡略化された実装例

grouped = df.groupby(quasi_identifiers)

anonymized_data = []

for name, group in grouped:

if len(group) >= k:

anonymized_data.append(group)

else:

# グループサイズがk未満の場合は汎化処理

generalized_group = self.generalize_group(group, quasi_identifiers)

anonymized_data.append(generalized_group)

return pd.concat(anonymized_data) if anonymized_data else pd.DataFrame()

def differential_privacy_noise(self, value, epsilon=1.0, sensitivity=1.0):

"""

差分プライバシーのためのノイズ追加

"""

scale = sensitivity / epsilon

noise = np.random.laplace(0, scale)

return value + noise

def hash_pii(self, pii_data, salt=None):

"""

個人識別情報のハッシュ化

"""

if salt is None:

salt = str(random.randint(1000, 9999))

salted_data = str(pii_data) + salt

hashed = hashlib.sha256(salted_data.encode()).hexdigest()

return hashed, salt

# プライバシー監査レポート

privacy_audit = {

'data_collection': {

'purpose_limitation': '明確',

'consent_mechanism': '実装済み',

'data_minimization': '適用中'

},

'data_processing': {

'anonymization': 'K=5で実装',

'encryption': 'AES-256適用',

'access_control': 'RBAC実装'

},

'data_retention': {

'retention_period': '24個月',

'deletion_mechanism': '自動削除設定',

'backup_policy': '暗号化済み'

}

}

成功事例に学ぶベストプラクティス

事例1: Netflix の推薦システム革新

Netflixは、PMとエンジニアの密接な協業により、世界最高レベルの推薦システムを構築しました。

成功要因の分析

- 技術とビジネスの統合: PMが協調フィルタリングとコンテンツベースフィルタリングの違いを理解し、ビジネス目標に応じて適切にアルゴリズムを選択

- 継続的実験: 年間1000回以上のA/Bテストを実施し、常に最適化を継続

- データ品質管理: 視聴履歴、評価データ、コンテンツメタデータの品質を厳格に管理

# Netflix型推薦システムの概念実装

class NetflixStyleRecommender:

def __init__(self):

self.user_profiles = {}

self.content_features = {}

self.interaction_matrix = None

def collaborative_filtering(self, user_id, n_recommendations=10):

"""

協調フィルタリングによる推薦

"""

# ユーザー類似度の計算

similar_users = self.find_similar_users(user_id)

# 類似ユーザーの嗜好に基づく推薦

recommendations = self.generate_cf_recommendations(

user_id, similar_users, n_recommendations)

return recommendations

def content_based_filtering(self, user_id, n_recommendations=10):

"""

コンテンツベースフィルタリングによる推薦

"""

user_profile = self.build_user_profile(user_id)

content_scores = self.calculate_content_similarity(user_profile)

recommendations = sorted(content_scores.items(),

key=lambda x: x[1], reverse=True)[:n_recommendations]

return recommendations

def hybrid_recommendation(self, user_id, cf_weight=0.7, cb_weight=0.3):

"""

ハイブリッド推薦システム

"""

cf_recs = self.collaborative_filtering(user_id)

cb_recs = self.content_based_filtering(user_id)

# スコアの重み付け統合

hybrid_scores = {}

for item, score in cf_recs:

hybrid_scores[item] = hybrid_scores.get(item, 0) + cf_weight * score

for item, score in cb_recs:

hybrid_scores[item] = hybrid_scores.get(item, 0) + cb_weight * score

final_recommendations = sorted(hybrid_scores.items(),

key=lambda x: x[1], reverse=True)

return final_recommendations

def measure_recommendation_quality(self, recommendations, actual_interactions):

"""

推薦品質の測定

"""

# Precision@K, Recall@K, NDCGなどの計算

precision_at_k = len(set(recommendations) & set(actual_interactions)) / len(recommendations)

return {

'precision_at_k': precision_at_k,

'coverage': len(recommendations) / len(self.content_features),

'diversity': self.calculate_diversity(recommendations)

}

事例2: Spotify の音楽発見エンジン

Spotifyは、機械学習を活用した音楽発見機能により、ユーザーエンゲージメントを大幅に向上させました。

技術的革新とPMの役割

- 自然言語処理の活用: 歌詞、レビュー、ブログ記事などのテキストデータから音楽の特徴を抽出

- 音響分析: 音楽の音響的特徴(テンポ、キー、音色など)をAIで分析

- リアルタイム学習: ユーザーの行動に基づいてリアルタイムで嗜好を更新

# Spotify型音楽分析システムの概念

class MusicAnalysisSystem:

def __init__(self):

self.audio_features = ['tempo', 'key', 'energy', 'danceability', 'valence']

self.text_features = ['genre_tags', 'mood_tags', 'lyric_sentiment']

def extract_audio_features(self, audio_file):

"""

音響特徴の抽出(概念実装)

"""

# librosaライブラリを使用した音響分析の例

features = {

'tempo': 120.5, # BPM

'key': 'C',

'energy': 0.8,

'danceability': 0.7,

'valence': 0.6 # 曲のポジティブさ

}

return features

def analyze_lyrics_sentiment(self, lyrics):

"""

歌詞感情分析

"""

# 自然言語処理による感情分析

sentiment_score = 0.3 # -1 (negative) to 1 (positive)

mood_tags = ['melancholic', 'introspective']

return {

'sentiment': sentiment_score,

'mood_tags': mood_tags

}

def generate_playlist(self, seed_tracks, target_features, length=20):

"""

シード楽曲を基にしたプレイリスト生成

"""

# 音響的類似性とテキスト的類似性を組み合わせた楽曲選択

playlist = []

for i in range(length):

# 段階的に特徴を変化させながら楽曲を選択

variation_factor = i / length * 0.3 # 30%まで特徴を変化

candidate_features = self.interpolate_features(

target_features, variation_factor)

next_track = self.find_best_match(candidate_features)

playlist.append(next_track)

return playlist

def measure_discovery_success(self, playlist, user_interactions):

"""

音楽発見の成功度測定

"""

# スキップ率、いいね率、プレイリスト追加率などを測定

skip_rate = user_interactions.get('skips', 0) / len(playlist)

like_rate = user_interactions.get('likes', 0) / len(playlist)

save_rate = user_interactions.get('saves', 0) / len(playlist)

discovery_score = (like_rate * 0.4 + save_rate * 0.4 +

(1 - skip_rate) * 0.2)

return {

'discovery_score': discovery_score,

'skip_rate': skip_rate,

'engagement_metrics': {

'like_rate': like_rate,

'save_rate': save_rate

}

}

実践的なスキル習得ロードマップ

フェーズ1: 基礎知識の習得(3-6ヶ月)

必須学習項目

- 統計学の基礎

- 記述統計、推定統計

- 仮説検定、信頼区間

- ベイズ統計の入門

- プログラミング基礎

- Python入門(pandas, numpy, matplotlib)

- SQL基礎(データ抽出、集計)

- Git/GitHub の使用方法

- 機械学習概論

- 教師あり学習、教師なし学習

- 評価指標の理解

- 過学習とバイアス・バリアンストレードオフ

# 学習進捗管理システム

class SkillDevelopmentTracker:

def __init__(self):

self.skills = {

'statistics': {

'level': 0,

'target': 7,

'resources': ['coursera_statistics', 'khan_academy'],

'assessments': ['quiz_1', 'project_1']

},

'programming': {

'level': 0,

'target': 6,

'resources': ['python_tutorial', 'sql_course'],

'assessments': ['coding_challenge', 'data_analysis_project']

},

'ml_fundamentals': {

'level': 0,

'target': 8,

'resources': ['andrew_ng_course', 'hands_on_ml'],

'assessments': ['ml_project', 'algorithm_comparison']

}

}

def update_skill_level(self, skill, new_level):

"""スキルレベルの更新"""

self.skills[skill]['level'] = new_level

# 目標達成チェック

if new_level >= self.skills[skill]['target']:

print(f"🎉 {skill} の目標レベルに到達しました!")

def get_learning_recommendations(self):

"""学習推奨事項の生成"""

recommendations = []

for skill, details in self.skills.items():

if details['level'] < details['target']:

gap = details['target'] - details['level']

priority = 'High' if gap > 3 else 'Medium' if gap > 1 else 'Low'

recommendations.append({

'skill': skill,

'priority': priority,

'gap': gap,

'next_resources': details['resources'][:2]

})

return sorted(recommendations,

key=lambda x: {'High': 3, 'Medium': 2, 'Low': 1}[x['priority']],

reverse=True)

# 使用例

tracker = SkillDevelopmentTracker()

tracker.update_skill_level('statistics', 5)

recommendations = tracker.get_learning_recommendations()

for rec in recommendations:

print(f"{rec['skill']}: {rec['priority']} priority, gap: {rec['gap']}")

フェーズ2: 実践的応用(6-12ヶ月)

実プロジェクトでの経験積み

- A/Bテスト設計・実行

- 実験設計の基本原則

- 統計的検出力の計算

- 結果の解釈と意思決定

- データ分析プロジェクト

- ビジネス課題の定義

- データ収集・前処理

- 分析結果のプレゼンテーション

- ML プロトタイプ開発

- 問題設定とデータ準備

- モデル選択・訓練・評価

- ビジネス価値の測定

フェーズ3: エキスパートレベル(12ヶ月以降)

高度なトピックス

- MLOpsの実装

- CI/CDパイプラインの構築

- モデル監視とアラート

- 継続的学習システム

- 倫理的AI開発

- バイアス検出・軽減

- 説明可能AI

- プライバシー保護技術

- 組織変革リーダーシップ

- データドリブン文化の構築

- エンジニア採用・育成

- 技術戦略立案

測定可能な成果指標と KPI 設計

ビジネス成果指標

AI プロダクトの成功を測定するためには、技術指標とビジネス指標を適切に関連付ける必要があります。

# KPI ダッシュボードの設計例

class AIProductKPIDashboard:

def __init__(self):

self.technical_metrics = {}

self.business_metrics = {}

self.correlation_analysis = {}

def define_kpi_hierarchy(self):

"""KPI階層の定義"""

return {

'north_star_metric': {

'name': 'Monthly Active Users',

'target': 1000000,

'current': 750000

},

'primary_metrics': {

'user_engagement': {

'session_duration': {'target': 25, 'current': 22},

'feature_adoption': {'target': 0.6, 'current': 0.45}

},

'model_performance': {

'accuracy': {'target': 0.85, 'current': 0.82},

'latency': {'target': 100, 'current': 120}

}

},

'supporting_metrics': {

'data_quality': {

'completeness': {'target': 0.95, 'current': 0.92},

'freshness': {'target': 24, 'current': 18}

},

'operational_efficiency': {

'deployment_frequency': {'target': 5, 'current': 3},

'error_rate': {'target': 0.01, 'current': 0.02}

}

}

}

def calculate_composite_score(self, metrics_dict):

"""複合スコアの計算"""

weighted_scores = []

for category, metrics in metrics_dict.items():

if category == 'north_star_metric':

continue

category_score = 0

for metric_name, values in metrics.items():

if isinstance(values, dict) and 'target' in values:

achievement_rate = values['current'] / values['target']

category_score += min(achievement_rate, 1.0)

else:

# ネストされたメトリクスの処理

for sub_metric, sub_values in values.items():

achievement_rate = sub_values['current'] / sub_values['target']

category_score += min(achievement_rate, 1.0) * 0.5

weighted_scores.append(category_score)

return sum(weighted_scores) / len(weighted_scores)

def generate_insights(self, kpi_data):

"""インサイトの自動生成"""

insights = []

kpis = self.define_kpi_hierarchy()

composite_score = self.calculate_composite_score(kpis)

if composite_score > 0.9:

insights.append("🚀 All systems performing excellently!")

elif composite_score > 0.7:

insights.append("✅ Good performance with room for improvement")

else:

insights.append("⚠️ Multiple areas need attention")

# 具体的な改善提案

for category, metrics in kpis.items():

if category == 'north_star_metric':

continue

underperforming = []

for metric_name, values in metrics.items():

if isinstance(values, dict) and 'target' in values:

if values['current'] < values['target'] * 0.8:

underperforming.append(metric_name)

if underperforming:

insights.append(f"Focus on improving: {', '.join(underperforming)}")

return insights

# 使用例

dashboard = AIProductKPIDashboard()

kpi_hierarchy = dashboard.define_kpi_hierarchy()

insights = dashboard.generate_insights(kpi_hierarchy)

print("KPI Insights:")

for insight in insights:

print(f" {insight}")

まとめ:AI時代のPMに向けたアクションプラン

AI技術の急速な発展により、プロダクトマネージャーの役割は従来の枠組みを大きく超えて拡張されています。成功するAI時代のPMになるためには、技術的理解力、データ分析スキル、エンジニアとの協業能力、そして倫理的判断力の4つの柱を同時に強化する必要があります。

即座に実行すべきアクション

- 基礎スキルの体系的習得: 統計学、機械学習、プログラミングの基礎を6ヶ月以内に習得

- エンジニアとの対話機会増加: 週2回以上の技術的議論の場を設定

- 実験駆動型プロダクト開発: 全ての機能開発にA/Bテストを導入

- 継続学習体制の構築: チーム全体での勉強会を月2回以上開催

中長期的な戦略

AI技術は今後も急速に進歩し続けるため、PMは常に学習し続ける姿勢が不可欠です。特に、GPT-4やその後継モデルのような大規模言語モデル、コンピュータビジョン、強化学習などの先端技術について、基本的な理解を保持し続けることが重要です。

また、技術的スキルの習得と並行して、AI開発に特有の倫理的課題、プライバシー保護、バイアス対策についても深い理解を持つ必要があります。これらの要素は、持続可能で社会に受け入れられるAIプロダクトを開発するために不可欠です。

エンジニアとの協業においては、単なる要件伝達者から、技術的パートナーとしての役割へと進化することが求められます。これにより、より革新的で実現可能なソリューションを共創できるようになります。

AI時代のプロダクトマネジメントは、技術とビジネスの境界を曖昧にし、より統合的なアプローチを要求します。この変化を機会として捉え、継続的な学習と実践を通じて、次世代のプロダクトリーダーとして成長していくことが、現代のPMに課された重要な使命といえるでしょう。